Hoe goed kunstmatige intelligentie is, wordt vaak gemeten aan het vermogen om mensen te verslaan in zero-sum-confrontaties (bijv. schaken, poker of go). Dat betekent dat er maar één buit te winnen valt: the winner takes all.Er wordt veel minder aandacht besteed aan momenten waar samenwerking met mensen voordelig is, zoals situaties waarin de voorkeuren van bot en mens verschillen of zelfs in conflict zijn. Samenwerken gaat over culturele normen, emoties en intuïtie – en een bot lost het dan niet op door naar cijfertjes te kijken.Daarom ontwikkelde Jacob Crandall samen met zijn onderzoeksteam van de Brigham Young University een algoritme dat (beter) kan samenwerken met mensen en andere algoritmes, dan dat mensen onderling samen kunnen werken. Dit laat zien dat een algemene samenwerking tussen mens en machine haalbaar is.Ooit gehoord van het gevangenendilemma? Zo niet, dan heb je het vast wel eens in een CSI-aflevering voorbij zien komen.Twee verdachten zijn opgepakt voor een ernstig misdrijf. Alles wijst erop dat ze allebei schuldig zijn, maar hard bewijs mist. Dus de openbaar aanklager geeft beide daders een kans:(1) je bekent en ik ga kijken wat ik voor je kan betekenen; of(2) je zwijgt.De deuren zijn gesloten, dus er kan niet worden gecommuniceerd. Hoe maak je dan de beste keuze?Als de daders allebei vertellen wat er is gebeurd, dan krijgen ze één jaar gevangenisstraf. Als ze allebei zwijgen, dan krijgen ze allebei twee jaar gevangenisstraf.Dat dilemma klinkt gemakkelijk op te lossen: een is minder dan twee. Maar dat is niet hoe mensen denken. Wat als de ene dader bekent, terwijl de ander z’n mond houdt? Dan zit hij drie jaar en de ander gaat vrijuit.Deze situatie kan ook meerdere keren worden uitgevoerd, waardoor je kunt zien hoe mensen op elkaar reageren en van elkaar leren uit voorgaande potjes. Dan kun je de gevangenisjaren zien als punten, geld of iets anders dat je graag wilt bemachtigen.Als spelers samenwerken, krijgen ze drie punten. Als ze allebei stil blijven, krijgen ze maar één punt. Als je de ander naait en toch niet samenwerkt, steel je vijf punten. En leg die laatste situatie maar eens uit als je nog een ronde moet spelen. Wat wordt je strategie? En waar kies je voor?Een mens maakt zo’n keuze op basis van intuïtie, culturele normen, emoties en signalen van de ander. Als je bijvoorbeeld drie keer achter elkaar bent genaaid of de ander lacht je ziek hard uit (omdat je in z’n val bent getrapt), is er een kans dat je wat anders doet dan wanneer hij spijt heeft.Ook is het voor een goede samenwerking belangrijk om af en toe met elkaar te kletsen. Dan kun je namelijk verantwoorden of uitleggen wat je de volgende keer gaat doen.Oké, maar het onderzoek ging over de samenwerking tussen robots en mensen. Niet over wie van de twee (mensen) de meeste punten kan behalen. Dus hoe verschilt een bot precies van een mens in het maken van een bepaalde keuze?Hieronder zie je een mechanisme waarbij een bot zijn ‘partner’ kan stimuleren om een eerlijke strategie te spelen. Je kan zien welke actie plaatsvond (het rode lettertje) en hoe de bot daarop reageert (het blauwe cijfertje) binnen iedere “staat”. Hoe werkt dat dan precies? Stel je voor dat de bot bijvoorbeeld tevreden was met de actie, dan gaf hij “Uitstekend!” als antwoord naar de speler. Als de speler hier positief op reageerde (en dus nog een keertje samenwerkte), dan riep de bot weer “Uitstekend!”. Dit gaat zo even door totdat de bot na vier keer samenwerken helemaal niks meer zegt. Als de speler dan nog een keertje samenwerkt, reageert de bot met “Nice, we worden rijk!”.Dit soort berichtjes kunnen natuurlijk ook negatief zijn. Dat is afhankelijk van het mechanisme. De bot kan een speler bijvoorbeeld ook straffen door niet samen te werken.Want uit het onderzoek wordt duidelijk dat deze small talk zowel bots als mensen helpt om sneller een patroon van (wederzijdse) samenwerking te ontwikkelen. Sterker nog, door deze small talk verdubbelde de hoeveelheid samenwerking tussen bots en menselijke spelers.Daarnaast viel het op dat bots onderling veel beter kunnen samenwerken dan mensen. Dit kwam door twee dingen. De bots waren geen enorme dramaqueens die per nieuwe ronde heel erg afweken in hun keuzes, zoals mensen die vaak om onduidelijke redenen wisselden tussen samenwerken en niet-samenwerken. Daarnaast logen mensen gewoon vaker over hun beloftes en wat ze gingen doen. Ze zeiden bijvoorbeeld dat ze wilden samenwerken, maar probeerden vervolgens toch meer punten te halen door het tegenovergestelde te doen. De bots hielden zich vaker aan hun woord; aangezien hun gedrag volledig op dit soor toezeggingen is gestoeld.Grappig feitje is dat de samenwerking tussen mensen net zo goed zou zijn als mensen zich (op deze twee punten) hetzelfde gedroegen als de bots. Het onderzoek laat zien dat autonome bots kunnen leren samenwerken met andere bots. Als mensen en bots beter willen gaan samenwerken, zal kunstmatige intelligentie menselijke emoties beter moeten leren begrijpen.Als dit verder wordt ontwikkeld, kan de angst over ‘slechte robots’ op ten duur misschien wel worden verminderd. En mocht ik in de tussentijd moeten samenwerken met een bot óf mens, dan weet ik wel wat ik kies: “Liever met een bot, dan een goede vriend.”Die mensen zijn niet te vertrouwen.

Het onderzoek laat zien dat autonome bots kunnen leren samenwerken met andere bots. Als mensen en bots beter willen gaan samenwerken, zal kunstmatige intelligentie menselijke emoties beter moeten leren begrijpen.Als dit verder wordt ontwikkeld, kan de angst over ‘slechte robots’ op ten duur misschien wel worden verminderd. En mocht ik in de tussentijd moeten samenwerken met een bot óf mens, dan weet ik wel wat ik kies: “Liever met een bot, dan een goede vriend.”Die mensen zijn niet te vertrouwen.

Advertentie

Advertentie

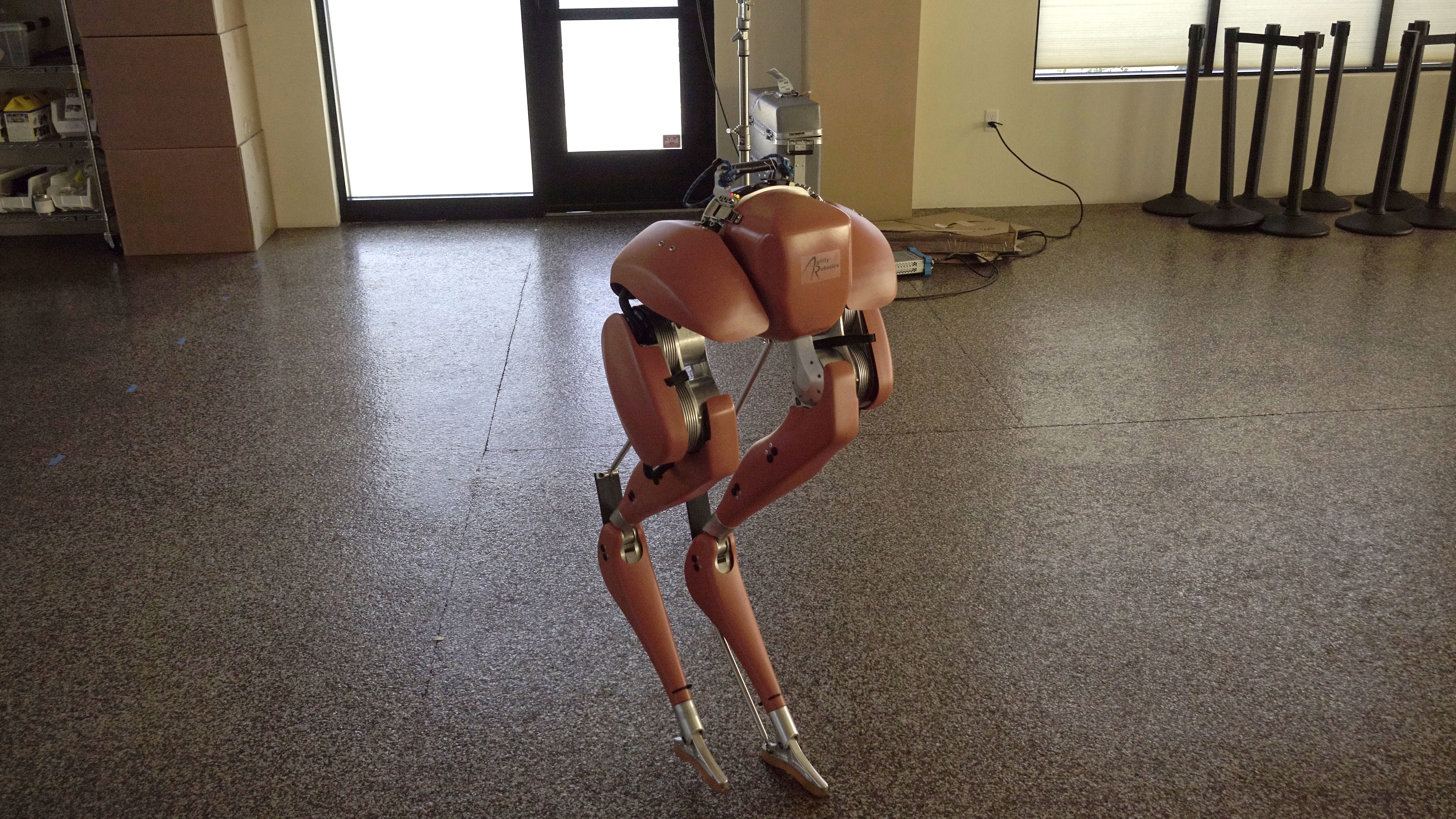

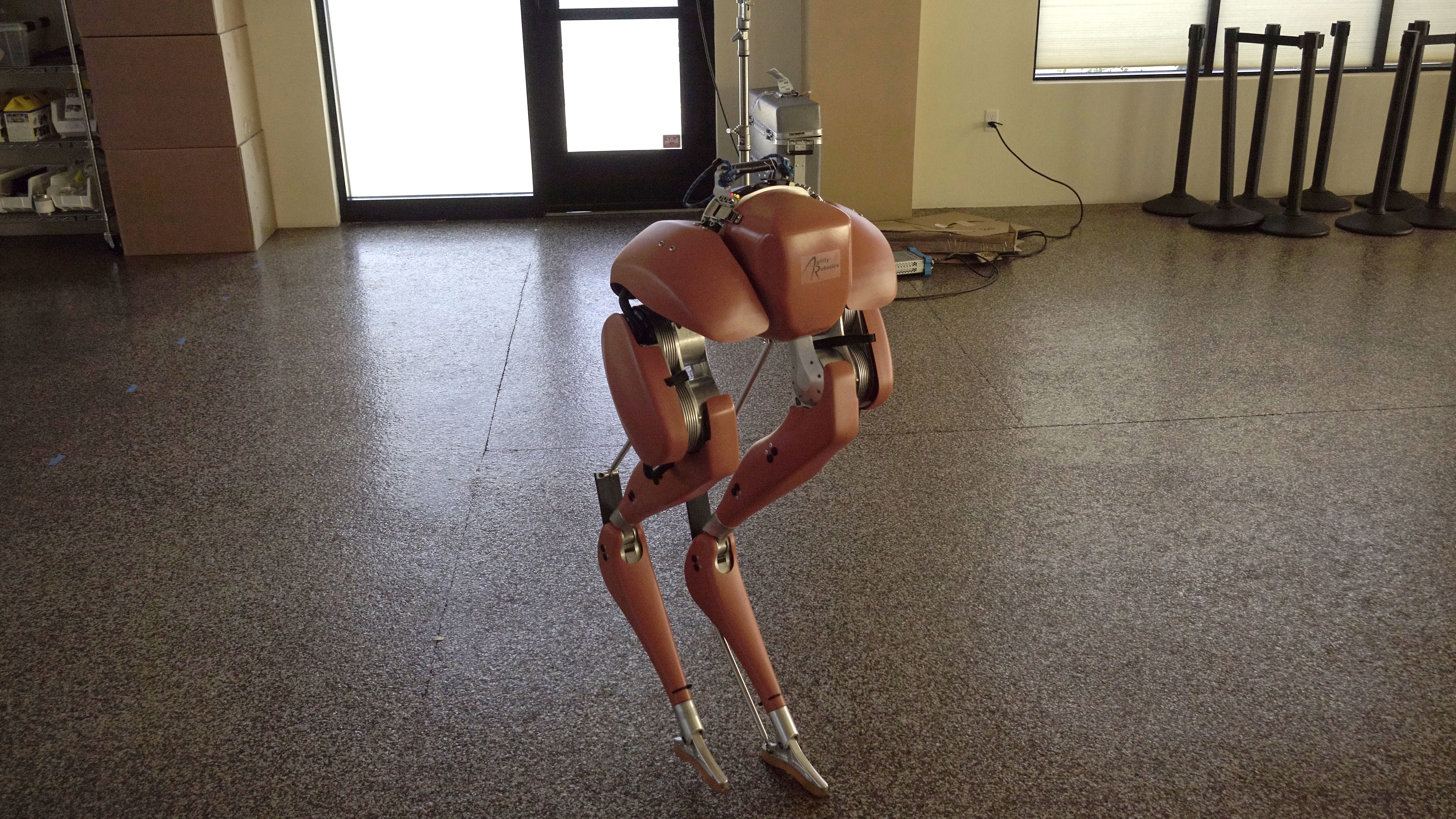

Crandall en zijn team geven aan dat robots hun strategische keuze op een heel andere manier maken dan mensen. Om het heel kort door de bocht uit te leggen: cijfertjes versus gevoel.Ze vroegen zich af of small talk invloed zou hebben op de samenwerking tussen bots en mensen. Daarom voerden ze in het totaal 472 zero-sum-games uit.Hierbij konden bots aan het begin van iedere ronde kant-en-klare berichtjes naar spelers sturen. Dit waren berichtjes als “Doe wat ik zeg, of ik straf je”, “Ik vertrouw je niet” of “Geef me een nieuwe kans.”. Met deze berichtjes kon een keuze worden verantwoord, een volgende actie besproken of een emotie worden geuit. Daarna kon er een nieuwe keuze worden gemaakt (check in het plaatje).

Advertentie

Advertentie