"Die isländische Regierung bezahlt 5000 US-Dollar für jeden Mann, der eine isländische Frau heiratet!" Facebook-Posts mit dieser sensationellen Schlagzeile, garniert mit einem Bild von drei jungen Frauen, werden Anfang August hundertfach geteilt. Aber die Story entbehrt jeder Grundlage und ist schlicht falsch.Verbreitet wird die Geschichte über Facebook-Seiten wie "SauLustig", "FunnyPics" oder "Anlauf statt Gleitgel". Tausendfach markieren Facebook-Nutzer ihre Freunde in den Kommentaren, um sie so auf die vermeintliche Sensation aufmerksam zu machen. Häufig sind es Männer zwischen 30 und 50. Unter den Tausenden von Kommentaren finden sich nur wenige Dutzend, die daraufhin hinweisen, dass der Artikel eine Falschmeldung ist.

Anzeige

Screenshot: Motherboard

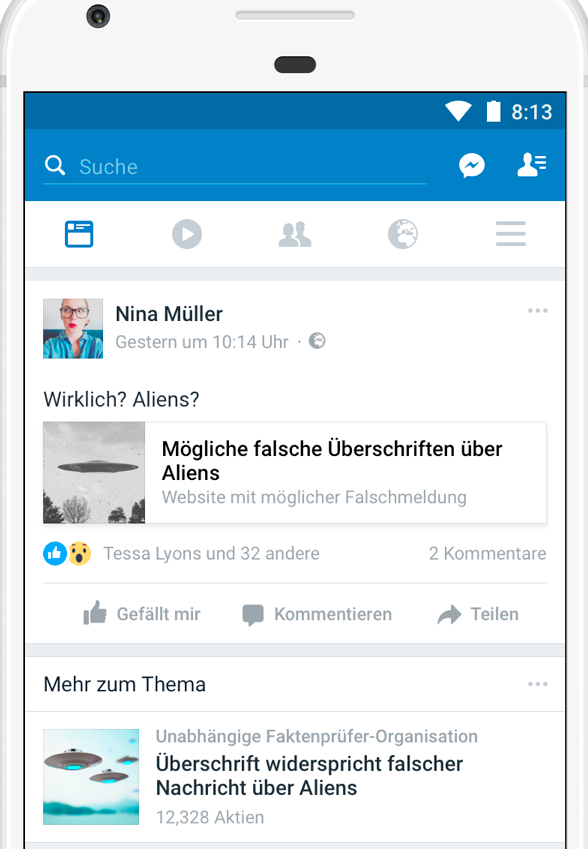

Dass sich Falschmeldungen so verbreiten, ist bekannt. Dennoch ist eins neu bei dieser Meldung: Es ist der erste Fall, bei dem Facebook ein speziell entwickeltes Tool in Deutschland einsetzt, mit dem das Netzwerk virale Fake News bekämpft.Den Kampf gegen Fake News führt Facebook über eine Anfang August weiterentwickelte Funktion, die als "Related Articles" bezeichnet wird. Im Falle der Posts über die isländische Heiratsprämie funktioniert das so: Unter dem Link zu einer Fake News erscheint automatisch ein weiterer sogenannter "Related Article". Dieser Artikel stellt klar, dass hinter dem Post, den ein User gerade angeklickt hat, eine Falschmeldung steckt. Auf deutsch werden solche Richtigstellungen unter der Überschrift "Mehr zum Thema" angezeigt, wie ein Anfang August von Facebook veröffentlichtes Bild mit einem Beispiel-Post über Aliens zeigt.

So funktioniert das neue Tool, das Fake News stoppen soll

Die Funktion der "Related Articles" gibt es bei Facebook schon seit fast vier Jahren. Doch erst mit dem jüngsten Update verbindet Facebook das Feature mit dem Kampf gegen Falschmeldungen. Auch wenn die Weiterentwicklung unscheinbar wirken mag, markiert sie einen großen Schritt für das Soziale Netzwerk. Dass Facebook mit inhaltlichen Richtigstellungen in die Feeds von Usern eingreift oder bewerten lässt, was wahr und falsch ist, war für den Konzern jahrelang undenkbar. Fast ein Jahr, nachdem das Unternehmen Ende 2016 für die Verbreitung von Fake News in die Kritik geraten ist, scheint sich das zu ändern. Hinter der "Mehr zum Thema"-Funktion steckt ein aufwändigeres und ausgeklügeltes System, das kurz vor der heißen Phase des Bundestagswahlkampfs jetzt auch in Deutschland gestartet ist.

Anzeige

Wie wird entschieden, was eine Falschmeldung ist und was nicht?

Anzeige

Einblicke in das interne Tool, mit dem die Faktenchecker arbeiten

Ungefähr so sieht das interne Facebook-Tool aus, auf dessen Grundlage die Faktenchecker Fake News markieren. Bis auf die Geschichte vom isländischen Männermangel sind alle in dieser stilisierten Nachzeichnung aufgeführten Posts nur Beispiele für in den vergangenen Monaten kursierende Falschmeldungen. Ob diese wirklich im Tool auftauchten oder gar von Faktencheckern als Falschmeldung markiert wurden, ist Motherboard nicht bekannt. Bild: Sabrina Schrödl | Motherboard.

Das Tool befindet sich unter einer spezifischen Subdomain von Facebook.com. Dass die Adresse des Programms innerhalb des normalen Facebook-Netzwerks liegt, erhöht ebenfalls die Sicherheit und Benutzbarkeit des Tools. Vom Design her unterscheidet sich das Programm kaum von der normalen Facebook-Gestaltung. Auch die verwendeten Schriftarten sind dieselben.Die Arbeitsoberfläche des Programms ist eine einfache Tabelle, die wir zum Verständnis oben in einer Illustration nachgezeichnet haben. Darin listet Facebook 600 möglicherweise falsche Posts auf, die dann von den Faktencheckern geprüft werden können. In jeweils fünf Spalten werden jedem Post verschiedene Informationen zugeordnet: Neben einer Nummer 1 bis 600 und eine Vorschau des umstrittenen Posts inklusive kleinem Bild und Überschrift wird den Faktenscheckern in der dritten Spalte die sogenannte Priorität angezeigt. Das ist ein von Facebook kalkulierter Wert auf einer Punkteskala von 1 bis 10. Er dient wohl als eine Art internes Ranking, das Orientierung darüber liefert, wie dringend diese Meldung gegengecheckt werden muss.

Anzeige

Die vierte und fünfte Spalte müssen die Faktenchecker ausfüllen: Jeder der Posts aus der Liste kann dort in einem Dropdown-Menü als wahr oder falsch markiert werden. Ist der Post eine Falschmeldung, tragen die Faktenchecker in der letzten Spalte einen Link zu einer Richtigstellung ein. Ab sofort wird diese Richtigstellung dann Nutzern unter der "Mehr zum Thema"-Funktion angezeigt. Im Falle des Posts über eine isländische Heiratsprämie konnten die Faktenchecker von Correctiv nach Abschluss ihrer Recherche mit wenigen Klicks die Richtigstellung verbreiten. "Kein Männermangel und auch keine Heiratsprämie in Island", heißt die Überschrift zu dem von Correctiv eingetragenen Artikel, den Journalisten aus dem selben Team auf ihrer Homepage veröffentlicht haben.Eine der wichtigsten bisher offenen Fragen ist, wie Facebook überhaupt auswählt, welche Artikel den Faktencheckern vorgelegt werden. Welche Posts landen in der 600 Artikel langen Liste der Prüfer, die für Facebook als Partner arbeiten? Wie genau die Vorselektion funktioniert, will Facebook auf Anfrage nicht verraten: Angaben zu den Details der Algorithmen mache man nicht. In einer offiziellen Pressemitteilung von Anfang August spricht Facebook lediglich davon "ab sofort verbessertes maschinelles Lernen zu nutzen. "Die Facebook-Algorithmen sollen also helfen, noch mehr potenzielle Falschmeldungen zu identifizieren und diese dann an externe Faktenprüfer weiterleiten", heißt es.Nicht immer haben die Algorithmen für die Vorselektion in der Vergangenheit jedoch perfekt funktioniert: Denn in der Tabelle landeten nicht ausschließlich Posts, die sich auch tatsächlich für eine Prüfung von Falschmeldungen eigneten. Als Motherboard das Tool einsehen kann, tauchen vereinzelt ebenfalls Posts auf, die für einen Faktencheck irrelevant sind. In einem Artikel geht es zum Beispiel darum, welcher Name denn nun die neue Haarfarbe eines Promis richtig bezeichnet. Allerdings scheinen die Algorithmen, die die Vorselektion der Artikel vornehmen, immer besser zu werden. Das könnte daran liegen, dass der Algorithmus Zeit hatte zu trainieren: Bevor das Programm nämlich jetzt in Deutschland anlief, lief es bereits seit März in den USA, Frankreich und den Niederlanden. Die Quote von für einen Faktencheck irrelevanten Posts soll jedoch inzwischen so gering sein, dass die Arbeit der Faktenchecker dadurch nicht gestört wird. Dennoch bleibt das Problem, dass nicht nachvollziehbar ist, wie die Vorselektion funktioniert und wie sich das Ranking der Priorität errechnet.

Welche Probleme es bei dem Programm noch gibt

Anzeige

In der Tabelle, mit der die Faktenchecker arbeiten, landen ausschließlich deutschsprachige Inhalte. Auf Motherboard-Anfrage erklärt Facebook nämlich, dass die Eingrenzung der vom neuen Fake-News-Tool bearbeiteten Posts über die Sprache funktioniert. Das bedeutet jedoch im Umkehrschluss auch, dass virale Falschmeldungen in russischer, türkischer oder arabischer Sprache von dem Programm nicht erfasst werden. Obwohl sich auch in diesen Communities in den vergangenen Monaten immer wieder Fake News verbreiteten, haben die Faktenchecker von Correctiv keine Chance, ihre Verbreitung auf Facebook einzufangen.Für die Arbeit der Faktenchecker ergibt sich noch ein Problem seit dem jüngsten Update von Anfang August: In der Tabelle erscheinen jetzt 600 und nicht nur wie zuvor 100 Posts. Für die Faktenchecker, die oft nur mit kleinen Teams arbeiten, ist das eine Masse, die kaum zu bewältigen ist.Doch es gibt noch ein Problem: Die "Related Articles"-Funktion kann nur bei sogenannten Link-Posts, nicht jedoch bei Bild- oder Video-Posts ausgespielt werden. Dabei sind es genau jene Posts, die der Facebook-Algorithmus momentan mit der größten Reichweite belohnt.Dementsprechend sind viele der viralsten Falschmeldungen aus den letzten Monaten Bild- und Videoposts. Besonders eindrücklich zeigt sich das am Beispiel eines viralen Hetzposts, mit dem rechte Facebook-Seiten nach dem Hamburger G20-Gipfel Jagd auf einen unbescholtenen Mann machen. Über hunderttausend Mal verbreitet sich der falsche Fahndungsaufruf gegen einen angeblichen Gewalttäter am Samstag nach dem Gipfel. Fast immer findet die Hetze in diesem Fall über einen Bild- oder Videopost statt. Die Faktenchecker von Correctiv wären hier machtlos gewesen: In der Tabelle auf deren Grundlage sie arbeiten, wäre keiner der Posts aufgetaucht.

Auch Videos rutschen durch

Anzeige

Auf eine Motherboard-Anfrage bestätigt Facebook, dass das "Related Article"-Feature derzeit nur für Artikel gilt." Allerdings entwickle der Konzern kontinuierlich neue Produkte, um auch für Bild- und Video-Posts Falschmeldungen zu erkennen und ihre Verbreitung einzudämmen. Schon heute setzt Facebook beispielsweise ein Tool gegen die Verbreitung von Clickbait-Videos ein. Dabei geht es allerdings nicht um den Inhalt der Videos, sondern darum, dass die Clips User auf unseriöse, manchmal mit Malware infizierte Websites locken sollen.In den USA, den Niederlanden und Frankreich kämpft Facebook schon seit März 2017 mit einer älteren Version des Tools gegen Fake News. Richtigstellungen werden dort nicht nur über "Related Articles", sondern per Warnhinweis angezeigt. In roter Schrift steht neben einer potentiellen Falschmeldung in den USA beispielsweise "Disputed." Dieser Hinweis, dass der Inhalt von Faktencheckern als unglaubwürdig eingestuft wird, erscheint auch automatisch, wenn ein User einen umstrittenen Artikel posten will.Warum also ist das Feature in Deutschland nicht früher an den Start gegangen? Der Grund für die Verzögerung ist einfach: Weil die finale Bewertung eines Artikels als Falschmeldung ein tiefgreifender Schritt ist, überträgt Facebook hier aus gutem Grund das journalistisch etablierte Vier-Augen-Prinzip auf das Anti-Fake-News-Tool. So ist auch eine gegenseitige Kontrolle der beteiligten Faktenchecker möglich. In Deutschland steht Correctiv zwar seit Januar als Partner fest, aber ein zweites Medium, das für Facebook Faktenchecks erledigen will, hat sich trotz langer Verhandlungen nicht gefunden.Doch am 3. August launcht Facebook ein Update des Programms, dass dieses Hindernis beiseite räumt. Dazu erklärt ein Sprecher: "Die Weiterentwicklung des ganzen Systems ermöglicht es, dass nur mit Correctiv gearbeitet werden kann." Was Facebook damit meint: Das Update der "Related Articles" führt dazu, dass von Faktencheckern geprüfte Posts nicht mehr – wie es in den USA, Frankreich und den Niederlanden der Fall war – als "umstritten" und damit als mögliche Falschmeldung bezeichnet werden – sondern dass die Richtigstellung lediglich über den Kontext der "Related Articles" angezeigt wird.Wie Facebook auf Nachfrage bestätigt, werden die "Disputed"-Warnhinweise in den USA, Frankreich und den Niederlanden auch nach dem Update vom August weiterhin eingesetzt – die "Related Articles" sind hier nur eine Ergänzung. Solange Facebook jedoch in Deutschland keinen weiteren Partner als Faktenchecker findet, kriegen wir hier erst einmal nur eine Light-Version.